그래서 사소한 질문을해서 묻히게 될 것 같은데 뭔가 좀 헷갈려요.

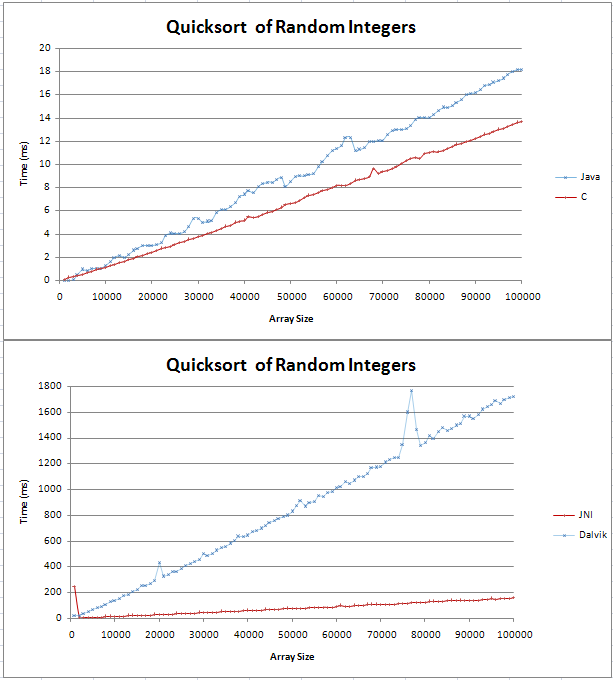

Java와 C로 퀵 정렬을 구현했으며 몇 가지 기본적인 비교를 수행했습니다. 그래프는 2 개의 직선으로 나 왔으며 C는 100,000 개의 임의 정수를 통해 Java보다 4ms 더 빠릅니다.

내 테스트 코드는 여기에서 찾을 수 있습니다.

(n log n) 선이 어떻게 생겼는지 확신 할 수 없었지만 직선이라고 생각하지 않았습니다. 나는 이것이 예상 된 결과이고 내 코드에서 오류를 찾으려고하지 않아야한다는 것을 확인하고 싶었습니다.

나는 공식을 엑셀에 집어 넣었고 10 진법의 경우 처음에는 꼬임이있는 직선 인 것 같습니다. log (n)과 log (n + 1)의 차이가 선형 적으로 증가하기 때문입니까?

감사,

Gav